Озеро знаний: зачем НЛМК построили Data Lake

Кулагин

руководитель направления Data Lake компании "Инфосистемы Джет"

Перед Новолипецким металлургическим комбинатом (НЛМК) стояла задача организовать работу с большими данными. Для ее решения компания выбрала концепцию Data Lake. Любое промышленное предприятие генерирует колоссальное количество информации, начиная с показателей датчиков со станков записей видеокамер, и заканчивая информацией от поставщиков. Поэтому перед ИТ-службами сегодня стоит вопрос не в целесообразности использования Big Data, а в том, какой из методов хранения и обработки информации использовать — создавать классическое структурированное хранилище или выбрать озеро данных, в котором можно хранить информацию в неизмененном виде.

Зачем заводу работать с данными

Один станок предприятия способен каждый месяц генерировать гигабайты информации. Например, лазерный дефектоскоп делает 86 000 записей событий в день при ежесекундной проверке. А если снимать с него показатели каждую миллисекунду в круглосуточном режиме, например, на прокатном стане, объемы данных будут еще более впечатляющими. Накопленные за исторический период Big Data, проанализированные алгоритмами, способны существенно улучшить процессы и принести реальную прибыль.

Например, чтобы получить прогноз о возможном сбое работы станка, система должна анализировать отклонения в его работе в реальном времени, и иметь доступ ко всему массиву записей за последние 5 месяцев.

Но игра стоит свеч, потому что оптимизация даже на 1-2% на отдельном участке технологического процесса позволяет достичь миллионной экономии за счет снижения затрат или повышения производительности.

Использование подобных технологий — мировой тренд, набирающий обороты: аналитики Gartner прогнозируют увеличение объема рынка искусственного интеллекта к 2021 до $2,9 трлн (по итогам 2018 — $1,2 трлн).

Почему именно озеро?

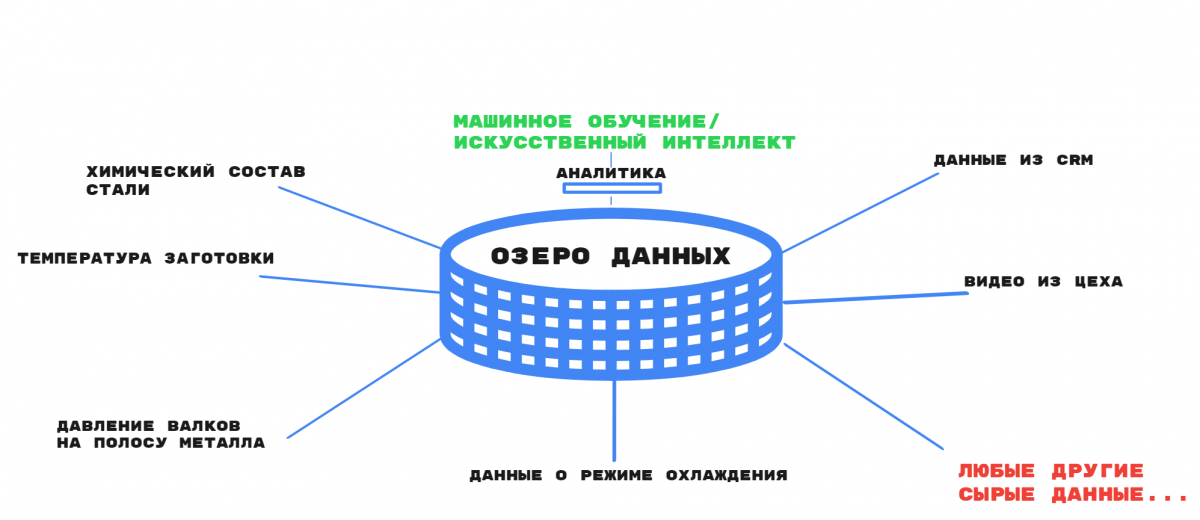

Для того, чтобы работать с Big Data, нужно хранить действительно большие объемы информации. И в случае с металлургией типов данных оказывается много: характеристики состава стали, уровни температур заготовок, параметры режимов охлаждения — все это дополняется множеством информации от поставщиков и подрядчиков. Современные станки с автоматизированным управлением регулярно "отчитываются" о своем состоянии в числовом формате, сообщая набор показателей каждую секунду или еще чаще. На серверы поступают текстовые сообщения, например, когда происходит ошибка, или web-система сообщает о каком-то событии. Все это дополняется видеоданными, которые поступают с камер охранных систем, а также электронными таблицами и документами от партнеров и поставщиков.

Data Lake отличается от других структур хранения тем, что позволяет собирать данные в исходном формате, без дополнительной и дорогостоящей обработки. Получить доступ к информации может любой авторизованный пользователь (в случае с НЛМК права доступа фиксируются на уровне Active Directory). При этом существует четкая система разделения доступа, и сотрудники каждого цеха могут работать только с теми данными, которые относятся к их собственному технологическому процессу. Для тех, кому нужен комплексный анализ, организован более широкий доступ. Например, старший инженер может увидеть полную картину и запросить любые данные, просто входя в систему под своей учетной записью.

Используя информацию из озера, специалисты могут проводить автоматизированный анализ, используя уже внедренные инструменты BI и ML, а также разрабатывать новые модели машинного обучения и тренировать алгоритмы искусственного интеллекта на базе актуальной и объективной информации. Такие подходы позволяют выбирать оптимальные объемы добавок для получения стали нужного качества.

Например, если начальнику цеха нужно оптимизировать расход сырья, он может составить прогноз на базе уже имеющихся данных. Для этого в систему ML загружается историческая информация о результатах производства, а искусственный интеллект вычисляет зависимость между входными параметрами и качеством стали. Так можно использовать экспериментальные данные, чтобы получить прогноз результата еще до выплавки новой порции стали.

Data Lake в данном случае выступает источником всех исторических данных и оказывается значительно дешевле в эксплуатации, чем другие хранилища, так как не требует ни длительного дорогостоящего проекта, ни подготовки данных для их хранения, ни высокопроизводительных серверов. Фактически для Data Lake нужна только емкость и правильно организованная иерархия хранения данных.

Масштабирование озера происходит на базе обычных серверов, и его размеры могут быть увеличены многократно за короткий отрезок времени и при относительно небольших затратах: подключение новых емкостей и вычислительных мощностей происходит без изменения инфраструктуры и перезапуска системы. Например, если в хранилище нужно добавить дополнительные 100 ТБ (этого хватит на полгода), а все RAID-массивы заняты, администратор просто подключает новый массив по локальной сети, и через 15 минут в Hadoop уже видны новые 100ТБ.

Тем не менее, использование озера не исключает наличия дополнительных хранилищ данных класса DWH. Напротив, выступая первичным источником данных, Data Lake упрощает процедуру заполнения структурированных хранилищ, которые могут потребоваться для решения узких задач. К тому же, если у завода уже есть DWH, в котором он хранит бухгалтерскую информацию или данные кадровой системы, отказываться от работающей системы нет никакого смысла. Однако можно переносить из нее архивные данные на новую платформу, освобождая место для новых записей.

Как устроено озеро данных на НЛМК

Big Data невозможно внедрить "одной кнопкой": если просто закупить серверы, вставить накопители и записать данные, ими нельзя пользоваться, при том что поддержка инфраструктуры будет по-прежнему требовать значительных затрат. Для того, чтобы результативно использовать машинное обучение, необходимо провести "домашнюю работу": внедрить технологии хранения данных с оптимальной архитектурой, правилами загрузки и описания данных.

Поэтому для реализации проекта по построению Data Lake в НЛМК привлекли ИТ-компанию "Инфосистемы Джет", одну из немногих компаний на рынке, имеющих реальный опыт работы с Big Data. Решающую роль сыграли успешно выполненные силами "Инфосистемы Джет" проекты для других промышленных предприятий.

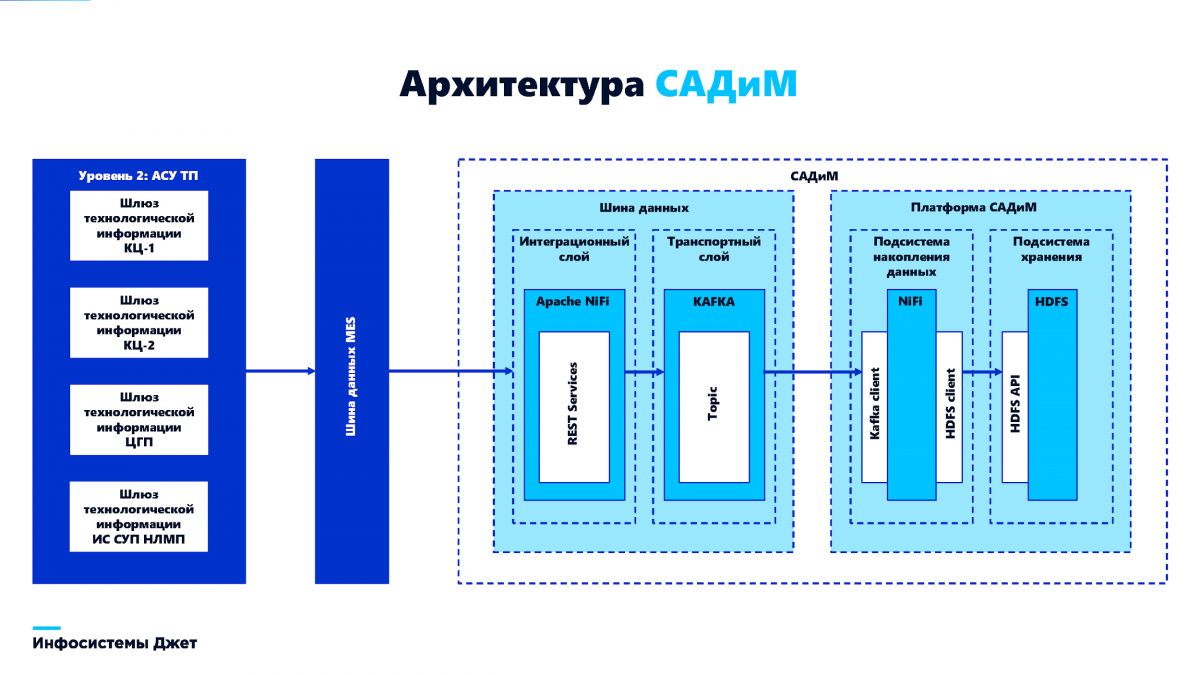

Концепцию хранилища ИТ-служба НЛМК создавала самостоятельно, а команда "Инфосистемы Джет" занималась реализацией проекта на базе платформы Arenadata Hadoop и внедряла дополнительные элементы системы: унифицированную витрину данных, систему контроля метаданных (на базе Apache Atlas), а также систему контроля доступа на базе ролевых моделей, привязанную к каталогам Active Directory.

На заводе уже была разработана концепция трансформации бизнес-процессов. В соответствии с ней ИТ-специалисты НЛМК внедрили систему анализа данных и моделирования (САДиМ) собственной разработки. Проект был запущен в сентябре 2019 года и уже через два месяца перешел в стадию продуктивной эксплуатации. В том числе это стало возможно за счет использования архитектуры Data Lake, которая позволяет получить данные в "сыром" виде и сохранить их для дальнейшей обработки.

На момент сдачи проекта была настроена передача данных в САДиМ из 70 источников, и их спектр будет расширяться в ближайшие месяцы. Также в систему были переданы исторические данные, накопленные за последние годы работы НЛМК в других хранилищах и информационных системах. Благодаря проведенным работам в Озере оказался максимально широкий спектр информации, доступной для анализа и тренировки алгоритмов искусственного интеллекта. С помощью команды "Инфосистемы Джет" на предприятии были построены карты данных технологических и производственных процессов с разбивкой на цеха и подразделения, чтобы с потоками информации было легче работать.

Что нужно знать о реализации таких проектов?

Создание Data Lake требует одновременной проработки стратегии хранения данных и направлений для машинного обучения. Также необходим запуск целого спектра интеграционных инициатив, которые позволят цифровой среде предприятия работать, как единое целое. Например, нужно обеспечить передачу данных в озеро из промышленных систем, настроить BI-инструменты для работы с уже имеющейся информацией и разработать интерфейсы для подключения дополнительных источников данных.

"Промышленные компании не заинтересованы в получении одного только ИТ-решения. В сущности, оно не имеет ценности без привязки к бизнес-процессам и реальным задачам. Только внутренняя экспертиза производственных процессов, наличие экспертов в области металлургии и глубокое погружение в процессы заказчика позволяют решать такие задачи, как построение универсальных хранилищ данных Data Lake", — отметил Дмитрий Кулагин, руководитель направления Data Lake компании "Инфосистемы Джет".

Первый этап: начните с пилота. В рамках пилота создаются первые оценочные модели машинного обучения. Они могут указать на реальные потребности, очертить структуру имеющихся данных и круг актуальных задач. Оценка моделей и перспектив улучшения показателей происходит с учетом экономического эффекта и трудозатрат на реализацию проектов диджитализации. Но самое главное, что на этапе пилотных проектов, которые велись в НЛМК внутренней командой ИТ-специалистов, выясняются конкретные требования к будущей экосистеме данных.

Второй этап: выработайте стратегию работы с данными (Data Science). Здесь, как правило, не обойтись без опытного консультанта, так как нужно формализовать категории данных, определить их жизненные циклы и бизнес-ценность.

Третий этап: создание Data Lake как основы для первичной консолидации данных. Специалисты "Инфосистемы Джет" рекомендуют переходить к этому этапу только после выполнения первых двух шагов. Очень важно предусмотреть базовую структуру хранения данных, обеспечить защиту и контроль доступа, чтобы не допустить утечек и нарушений закона по защите информации.

Также необходимо продумать связки и интеграцию Озера с аналитическими системами, чтобы в любой момент можно было классифицировать сохраненные данные и использовать их. В противном случае можно получить "болото" с данными непонятного происхождения, из которых практически невозможно извлечь пользу.

При грамотном построении системы предприятие получает возможность накопления данных, даже если они еще не применяются для решения реальных бизнес-задач. Наличие записей исторических показателей с разнообразных датчиков и сенсоров может оказаться бесценным для дальнейшего построения и совершенствования ML-моделей. Благодаря этой информации вы сможете обеспечить ту самую "оптимизацию на несколько процентов", которая приносит предприятиям миллионы рублей.